6月6日至7日,第七屆智源大會在北京舉行,被“眾星捧月”的嘉賓從去年的月之暗面創始人楊植麟變更為今年的宇樹科技CEO王興興。在多位與會人士看來,一輪又一輪明星公司或創業者崛起的背后,AI(人工智能)越來越快的發展速度是核心驅動力。

參與主論壇的圖靈獎得主、深度學習領域奠基人之一的蒙特利爾大學教授Yoshua Bengio稱:“我們低估了AI進步的速度。”面壁智能CEO李大海也在采訪中表示,技術的發展是非線性的,大模型作為基礎技術與基礎設施,待未來發展到一定程度后,行業一定會更關注基礎設施之上的應用,這是行業合理規律。

今年智源大會傳遞出的AI重點從大語言模型的預訓練,更迭為世界模型的培育發展。智源研究院院長王仲遠表示,AI正加速從數字世界走向物理世界,也因此,智源研究院宣布從“悟道”時代邁入“具身智能”探索階段。

何為世界模型

對于世界模型的精準定義,王仲遠在采訪中表示,目前世界范圍內暫時沒有共通的定義,已存在的名稱包括“空間智能”“時空智能”等。此次智源研究院發布的一系列相關產品與技術,也代表了自身對世界模型的理解。

智源發布大模型產品可以追溯至2021年3月的悟道1.0,作為中國首個超大規模信息智能模型,悟道1.0填補了中文超大預訓練模型生態的空白。悟道2.0在知識推理、多語言生成等方面逐漸提速。2023年的悟道3.0開始在通用視覺與多模態等方面取得突破。

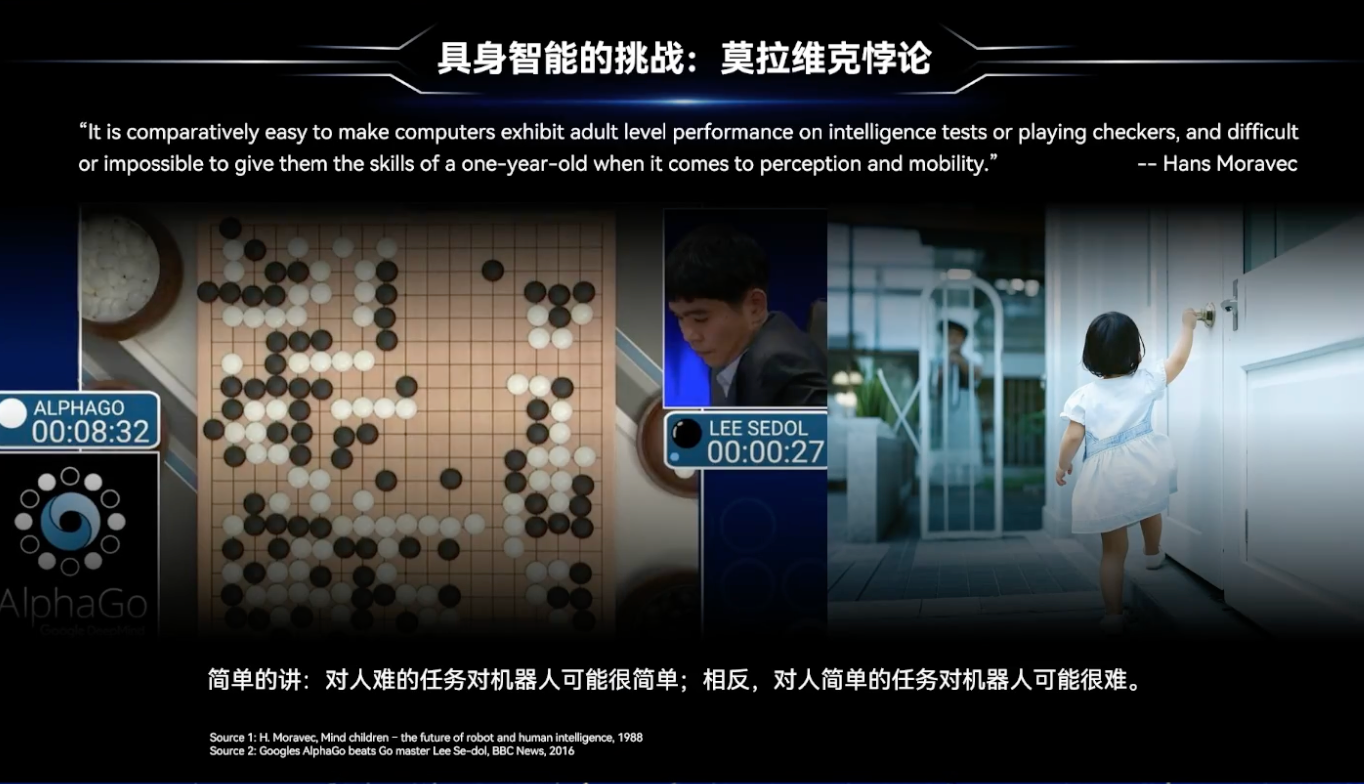

近年來,大語言模型和多模態模型的發展,進一步推動機器人從1.0時代邁向2.0時代。目前,大模型與機器本體深度耦合,進而驅動以具身智能為核心的機器人2.0時代,正在加速數字世界與物理世界融合。

因此今年,智源推出“悟界”系列大模型,承載的是智源對人工智能從數字世界邁向物理世界的技術趨勢判斷與思考。具體來講,“悟界”系列包括原生多模態世界模型Emu3、腦科學多模態通用基礎模型見微Brainμ、跨本體具身大小腦協作框架RoboOS 2.0與具身大腦RoboBrain 2.0以及全原子微觀生命模型OpenComplex2。

其中,Emu3對多模態技術的升級迭代具有重要作用。多模態是通往AGI(通用人工智能)的必由之路,系同時使用多種不同類型的數據形式——如圖像、文本、語音、視頻、傳感器信號等,來共同表達信息或完成任務的技術或系統。

此次Emu3升級的意義在于,傳統多模態訓練方法需要復雜的擴散模型或將不同模態分開處理再組合,但Emu3不需要這些復雜操作,可以通過一種新的視覺tokenizer(可以把圖像和視頻轉換成類似文字的符號序列),將圖像與視頻變成和文本一樣的離散符號,進而在一個統一框架里處理所有模態數據。這意味著模型可以在一個模態上學習到的知識直接遷移到其他模態上,大幅簡化多模態學習的復雜性。

王仲遠表示,大模型技術過往基于互聯網數據,尤其是互聯網文本數據訓練而來,固然對知識的理解很強,但對真實世界的運作規律并不理解。AI從數字世界跨向物理世界時必須突破數字世界的隔閡,最重要的隔閡和邊界是空間和時間的感知。這也是此次智源一系列AI產品進行具身與腦科學等行業落地時,可以進一步探索的方向。

底座大模型如何破瓶頸

無論是物理世界還是數字世界,AI落地都需要底座大模型的智能化支撐。

王仲遠認為,大模型技術還遠沒有到發展的盡頭,過往所說的“百模大戰”更多的是大語言模型的競爭,而大語言模型受限于互聯網數據的使用,基礎模型性能雖然還在提升,但是提升速度不如以前,突破瓶頸的解法包括強化學習、數據合成、多模態數據三方面。

強化學習在后訓練和推理方面的提升作用已明確表現在OpenAI o1、o3、o4、DeepSeek R1等產品上,合成數據目前學術界仍在努力突破。至于多模態數據,在全世界范圍內,多模態數據規模可達文字數據的百倍、千倍甚至萬倍以上,但這些數據遠未被高效利用,多模態技術的發展也是本屆大會討論的重點之一。

去年智源便對大模型的技術路線進行了預判:從大語言模型向多模態,尤其是原生多模態世界模型的方向發展。而原生多模態世界模型本質上是為了讓AI感知和理解物理世界,進而推進與物理世界的交互。進入物理世界之后,在宏觀層面,大模型與硬件結合,通過具身智能的發展解決實際生產生活問題。

針對物理世界對數據需求量大、目前多模態數據又不足的難題,王仲遠表示這是具身智能目前存在循環悖論——具身能力不足限制了真機數據的采集,數據稀缺導致模型能力弱、落地難,無法進一步提升能力。這一困難從不同角度出發有不同解法,智源走的是大模型路線,更多依靠互聯網數據幫助機器人學習智能。

具體訓練方式表現為不斷學習海量已有數據,再通過強化學習和少量真實世界的數據不斷訓練其能力,不斷突破具身智能的發展上限,這與大模型發展路線不謀而合,基礎能力發展到一定程度后,可以通過強化學習進一步激發智能化程度。

需注意的是,王仲遠強調,由于目前具身領域的技術路線尚未收斂,不同廠商、不同團隊都在用不同方式進行探索,智源走的技術路線目前只是“一家之言”。

具身熱但發展狀態尚早

具身智能不僅是智源提及世界模型與物理世界建立聯系的“渠道”之一,更是此次大會重點核心議程。

智源提供的解決方式之一便是跨本體的具身大腦,未來行業可以通過具身智能的融合模型突破硬件構型、數據類型,使得這些數據能夠被真正有效集成起來,這樣采集的真機數據不會被浪費。但同時,王仲遠表示,具身大腦的跨本體相對較為容易,而具身大腦最重要的是感知與理解世界,通過與世界交互,完成任務規劃與指令拆解,這部分僅僅通過大腦是不夠的,還需要指揮硬件本體,后者是更大的挑戰。

另外,跨本體的小腦技能目前還未完全掌握技術路線。王仲遠以美國機器人初創公司PhysicalIntelligence為例,該公司已經能夠將各種硬件采集下來的數據用于模型訓練,進而得到更加泛化的能力,目前來看該路線具備一定效果,但還并未達到行業廣泛共識的水平。想要真正實現跨本體、跨硬件的具身智能小腦模型,還需要硬件在一輪輪的產業迭代中進行淘汰與收斂。

另在北京人形機器人創新中心有限公司CTO唐劍看來,機器人行業發展還面臨多項痛點,第一就是機器人的場景泛化能力差,比如一款機器人只能工作在一個場景內,打螺絲的專職打螺絲,酒店送餐的專職送餐,很難看到原來干打螺絲工作的機器人跑去酒店送餐。即使在單一場景內,機器人也需要搭載不同的程序與軟件來完成,因此機器人的任務泛化能力也很差。第三點便是機器人的本體泛化能力差,廠商一般針對具體某一類工作場景設計一款機器人本體。

至于控制技術層面,唐劍以行業過去常用的MPC(基于數學模型預測的控制,Model Predictive Control)為例,該控制方式的優點包括高可靠性、高確定性、高精確度,但也伴隨預編程(單一場景任務)、僅適用于結構化環境、僅適用于固定流程與操作對象等缺點。

整體來看,王仲遠總結稱:具身大模型的發展仍處于非常早期的階段,可類比大模型在GPT-3 之前的技術探索期,具體包括技術路線尚未形成共識,學界與產業界對核心技術路徑存在分歧,仿真數據、強化學習、大小腦融合架構等方向仍在探索中,尚未形成統一方法論;另外產業落地尚需突破,盡管智源推出具身智能跨本體大小腦協作框架等成果,但離大規模商用仍有較長距離,需解決“感知-決策-行動”協同、多模態數據融合等基礎問題。具體技術路徑的成熟與產業落地仍需多方長期共同努力。

幫企客致力于為您提供最新最全的財經資訊,想了解更多行業動態,歡迎關注本站。鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播更多信息之目的,如作者信息標記有誤,請第一時間聯系我們修改或刪除,多謝。