本站5月7日消息,理想汽車今日晚間推出“理想AI Talk第二季——理想VLA司機大模型,從動物進化到人類”,理想汽車董事長兼CEO李想分享了對于人工智能的最新思考,VLA司機大模型的作用、訓練方法和挑戰,以及對于創業和個人成長的見解。

李想將AI工具分為三個層級,分別是信息工具、輔助工具和生產工具。

目前,大多數人將AI作為信息工具使用,但信息工具常伴隨大量無效信息、無效結果和無效結論,僅具參考價值。

成為輔助工具后,AI可以提升效率,例如現在的輔助駕駛,但仍需人類參與。

未來,AI發展為生產工具后,將能獨立完成專業任務,顯著提升效率與質量。

李想表示:“判斷Agent(智能體)是否真正智能,關鍵在于它是否成為生產工具。只有當人工智能變成生產工具,才是其真正爆發的時刻。就像人類會雇傭司機,人工智能技術最終也會承擔類似職責,成為真正的生產工具。”

代入到自動駕駛領域來看,李想表示,目前的L2、L2 組合駕駛輔助仍屬于輔助工具階段。

而VLA(Vision-Language-Action Model,視覺語言行動模型)能夠讓AI真正成為司機,成為交通領域的專業生產工具。對理想汽車而言, 未來的VLA就是一個像人類司機一樣工作的司機大模型”。

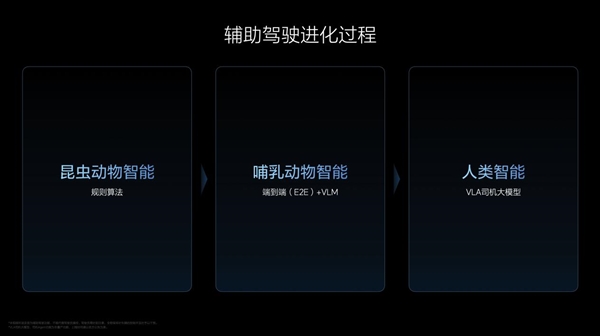

VLA的實現不是一個突變的過程,是進化的過程,經歷了三個階段,對應理想汽車輔助駕駛的昨天、今天和明天。

第一階段,理想汽車自2021年起自研依賴規則算法和高精地圖的輔助駕駛,類似“昆蟲動物智能”。

第二階段,理想汽車自2023年起研究,并于2024年正式推送的端到端 VLM(Vision Language Model,視覺語言模型)輔助駕駛,接近“哺乳動物智能”。

端到端模型在處理復雜問題時存在局限,雖可借助VLM視覺語言模型輔助,但VLM使用開源模型,使其在交通領域的能力有限。同時端到端模型也難以與人類溝通。

為了解決這些問題并提升用戶的智能體驗,理想汽車自2024年起開展VLA研究,并在多項頂級學術會議上發表論文,夯實了理論基礎。

第三階段,在端到端的基礎上,VLA將開啟“人類智能”的階段,它能通過3D和2D視覺的組合,完整地看到物理世界,而不像VLM僅能解析2D圖像。

同時,VLA擁有完整的腦系統,具備語言、CoT(Chain of Thought,思維鏈)推理能力,既能看,也能理解并真正執行行動,符合人類的運作方式。

此外,李想還進一步分享了VLA的訓練細節和運作原理。

VLA訓練分為預訓練、后訓練和強化訓練三個環節,類似于人類學習駕駛技能的過程。

預訓練相當于人類學習物理世界和交通領域的常識,通過大量高清2D和3D Vision(視覺)數據、交通相關的Language(語言)語料,以及與物理世界相關的VL(Vision-Language,視覺和語言)聯合數據,訓練出云端的VL基座模型,并通過蒸餾轉化為在車端高效運行的端側模型。

后訓練相當于人類去駕校學習開車的過程。隨著Action(動作)數據的加入——即對周圍環境和自車駕駛行為的編碼,VL基座變為VLA司機大模型。

強化訓練類似于人類在社會中實際開車練習,目標是讓VLA司機大模型更加安全、舒適,對齊人類價值觀,甚至超越人類駕駛水平。

VLA司機大模型以“司機Agent(智能體)”的產品形態呈現,用戶可通過自然語言與司機Agent溝通,跟人類司機怎么說,就跟司機Agent怎么說。

簡單通用的短指令由端側的VLA直接處理,復雜指令則先由云端的VL基座模型解析,再交由VLA處理。

李想強調:理想人工智能走的是無人區,做VLA這件事,Deepseek、OpenAI、谷歌、Waymo都沒有走過這條路,理想以前走的是汽車的無人區,以后走的是人工智能的無人區。

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播更多信息之目的,如作者信息標記有誤,請第一時間聯系我們修改或刪除,多謝。