本站5月20日消息,NVIDIA宣布,TensorRT AI推理加速框架現(xiàn)已登陸GeForce RTX顯卡,性能比DirectML直接翻倍。

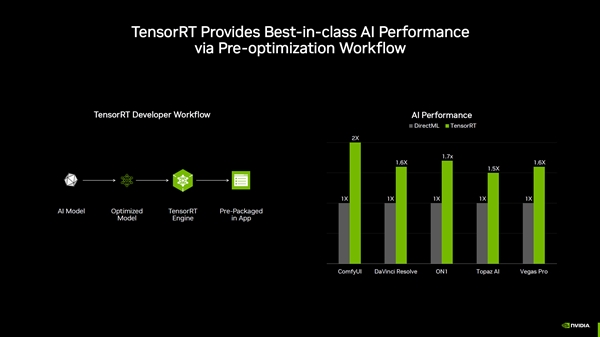

TensorRT是NVIDIA推出的一種推理優(yōu)化器,能夠顯著提升AI模型的運行效率,此次,NVIDIA將TensorRT引入RTX平臺,使得所有RTX顯卡的用戶都能享受到更快的AI性能。

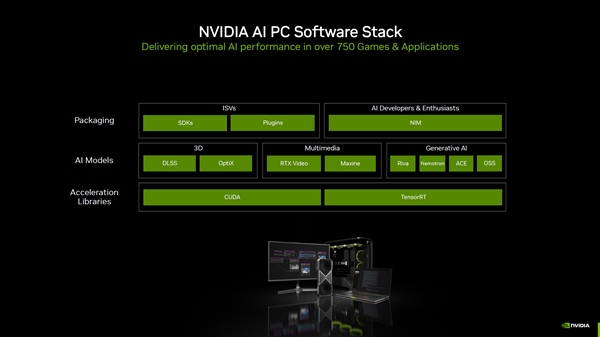

根據(jù)NVIDIA的介紹,TensorRT不僅支持原生Windows ML,還能夠自動選擇合適的硬件來運行每個AI功能,并下載相應(yīng)的執(zhí)行提供程序,極大地簡化了開發(fā)流程。

在性能方面,NVIDIA展示了TensorRT與DirectML的對比數(shù)據(jù):在ComfyUI中,使用TensorRT的用戶可以獲得高達2倍的性能提升;在DaVinci Resolve和Vegas Pro中,性能提升達到了60%。

此外,TensorRT for RTX還帶來了其他優(yōu)勢,例如8倍更小的庫文件大小和針對每個GPU的即時優(yōu)化,這些改進不僅提升了性能,還優(yōu)化了軟件的存儲和管理。

TensorRT for RTX將在6月正式推出,NVIDIA還在不斷擴展其AI SDKs,目前正為超過150個AI SDK提供支持,本月將推出5個新的ISV集成,包括LM Studio、Topaz Video AI、Bilibili、AutoDesk VRED和Chaos Enscape等。

鄭重聲明:本文版權(quán)歸原作者所有,轉(zhuǎn)載文章僅為傳播更多信息之目的,如作者信息標記有誤,請第一時間聯(lián)系我們修改或刪除,多謝。