眾所周知,AI 的能力有多強,那它開始胡扯的時候就有多煩。

它既會一本正經的編造著從沒見過的事情。

也會在最簡單的比大小問題上栽跟頭。

從兩年前驚艷問世的 ChatGPT、到如今默默落地的 DeepSeek V3.1,沒有一個大模型,能逃過幻覺這個坎。

為什么大模型離不開幻覺?

這個問題本身,在互聯網上也成了未解之謎,不過上周 OpenAI 的一篇論文里,倒是提出來一個蠻有趣的觀點。

“造成 AI 幻覺的根本原因,可能是來自于人類訓練 AI 的過程”

簡而言之,不是 AI 不行,而是我們訓練它的方式不對,都怪我們 CPU 它。

為啥要把這鍋甩給人類?

要回答這個問題,就得從內外兩個層面來理解大模型。

一方面,大模型訓練的機制就決定了,它們天生就容易產生幻覺,這就是 AI 幻覺的“內憂”

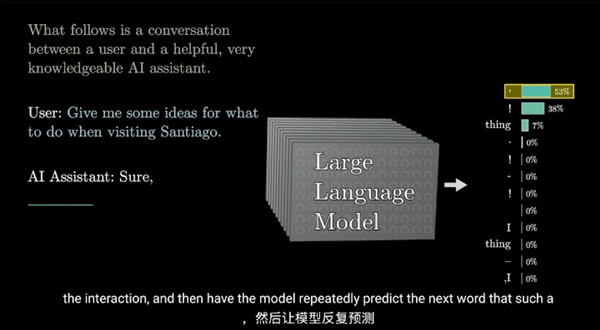

在訓練模型的時候,模型要從海量的文本里,學到能夠預測出下一個單詞的能力。

因此, 只要一句話看起來像是個人話,那么模型就會開始學習它的結構,

但模型有時候只顧著學結構了,這句話的內容到底對不對,它可分辨不了。

而當我們對模型提問的時候,模型也會優先想著,把這句話給回答個完整,但問題是,不是所有的提問,都會有個明確的答案。

舉個例子,咱們如果拿出火鍋的照片來讓大模型判斷這是什么動物,那么模型就會開始分析火鍋的特征,發現它的毛是金色的,又很長很大只,同時可能又有 92.5%的概率是只狗。

而模型在過去的學習過程中,是能夠從不同的圖片中,學些到狗子的長相特征的。于是把這些特征給連接起來一判斷,就會發現它有很大的概率是一只金毛。

但是如果咱們換個問題,問它火鍋是哪年哪月出生的,那大模型就直接懵逼了啊,這個問題,模型肯定沒學過,光是看圖像,誰也沒法知道這只狗的生日是啥時候。

如果此時模型還在硬著頭皮回答,隨便編了個答案拋出來,那就變成了我們常說的幻覺問題了。

產生幻覺,可以說是大模型的天性,或者換個角度來說,大模型的本質就是詞語接龍,只不過答對了的題目會被我們認為是正確,答錯了的題目被我們稱之為幻覺。

同時另一方面,我們現在訓練大模型,給模型打分評估的方式,也是的讓模型的幻覺問題變得更加嚴重的“外患”。

還是剛才那個問生日的問題,咱們把訓練的過程簡化一下:

假設模型回答對了一個問題,加一分,回答錯了問題則不加分。

那么當我們問它火鍋的生日的時候,如果模型直接選擇擺爛,說不知道,那么它一輩子都只是個零蛋。

但是如果它開始瞎猜,隨便說個日期出來,那么可能會有三百六十五分之一的概率給它蒙對了。

一邊是絕對失敗,一邊是幾百分之一的概率答對。

只要模型選擇了瞎猜,那么它最后的平均得分,就永遠都比放棄做答要來的高一些。

所以,為了能讓自己在人類定制的排行榜里刷到更高的分,越來越多的大模型也失去了說:“我不知道” 的權利,對于追求分數的模型來說,瞎猜成了唯一的理性選擇,而誠實則是一種最愚蠢的策略。

OpenAI 的研究人員還觀察了一下目前主流的各類大模型排行榜。

結果發現大家都是通過這種“只分對錯”的方式,來測試大模型的能力。

本意是用來衡量模型能力的考題,反而變成了促使大模型幻覺的“外患”。

為了驗證這種“應試思維”到底有多大影響,OpenAI 就拿自己旗下的倆模型做了個對比,結果它就發現,在刷題的時候,老模型 o4-mini 的正確率,甚至還要比新模型 GPT-5 要高了 2 個百分點。

不過代價呢,是有四分之三的問題全都答錯了,只有 1% 的題目,o4-mini會干凈利落的承認大模型是有極限的。

而 GPT-5 在這方面則是善變的多,遇到自己不會的問題,會直接了當的承認自己不知道。

這也是 OpenAI 對 GPT-5 最認可的地方,雖然它刷榜考試,面對應試教育的能力變差了,但是它學會認錯了呀。

在論文的最后,OpenAI 還搬出來了幾個有趣的觀點:

他們認為對大模型來說,幻覺沒有辦法消除,只能想辦法來避免。

因為不管模型大小,搜索信息和推理文本的能力有多高,這個世界上一定是有問題是沒有答案的。

而面對這些沒有答案的問題,模型要學會從應試教育中跳出來,勇敢的回答說我不知道。

同時比起大模型來說,小模型反而更容易意識到自身的局限性。

因為很多知識小模型可能根本沒學過,所以人家反而會干脆利落的承認我不會,但是大模型因為啥都學會了一點,所以面對一些題目的時候可能就會很自信的 A 上去了 。

結果沒學透,反而把問題給答錯,好事做成了壞事,就變成了幻覺。

最后,作為指導模型的人類,我們也要重新去設計評估模型能力的方式,重新設計訓練模型的體系,來降低模型瞎猜的概率。

看起來是挺有道理的,不過 —— 話又要說回來了。

一個沒有幻覺的大模型,真的是我們需要的嗎?

換個角度來說,如果兩年前,大模型對自己不能確定的一切問題,都在會回答:“對不起,我不知道”,那么這種瘋狂道歉,用戶體驗稀爛的 AI,或許根本不會火起來。

實際上,這兩年也有越來越多的研究發現,模型的創造力和幻覺,其實是一個相輔相成的兩面。

一個不會出現幻覺的模型,或許也會同步失去創造的能力。

就拿剛發布的 GPT-5 來說,雖然 OpenAI 用了上面提到的很多辦法,讓它出現幻覺的概率降低了。

但是同樣的,整個模型也變得失去了人味,沒有激情,變蠢了。

對面同樣的問題,GPT-5 表示的冷靜的多

原本不少人一天前,還在和 GPT4o 談著甜甜的戀愛呢,結果一覺醒來,奧特曼把老模型全給砍了。

幻覺概率變少的 GPT-5 變成了一個冷冰冰的理科生,或許它寫代碼的能力變強了,但是一到了聊聊天,文藝創作這些領域,就變得好像是一個小腦被閹割的呆子。

這你受得了嗎,于是憤怒的網友們發起了“拯救 4o” 的網絡運動。

鬧到最后,山姆奧特曼也是認了慫,給大家重新開放了老模型的權限。

所以,一味的抑制模型的幻覺,真的是件好事么?

到底是允許模型犯錯,還是要讓它什么都不做,這或許沒有一個標準的答案,每個人的選擇,都各有不同。

或許有一天,用戶真會嫌棄 AI 太“老實”,沒有靈氣;

但在另一邊,還有人則更想要一個可信賴的伙伴

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播更多信息之目的,如作者信息標記有誤,請第一時間聯系我們修改或刪除,多謝。